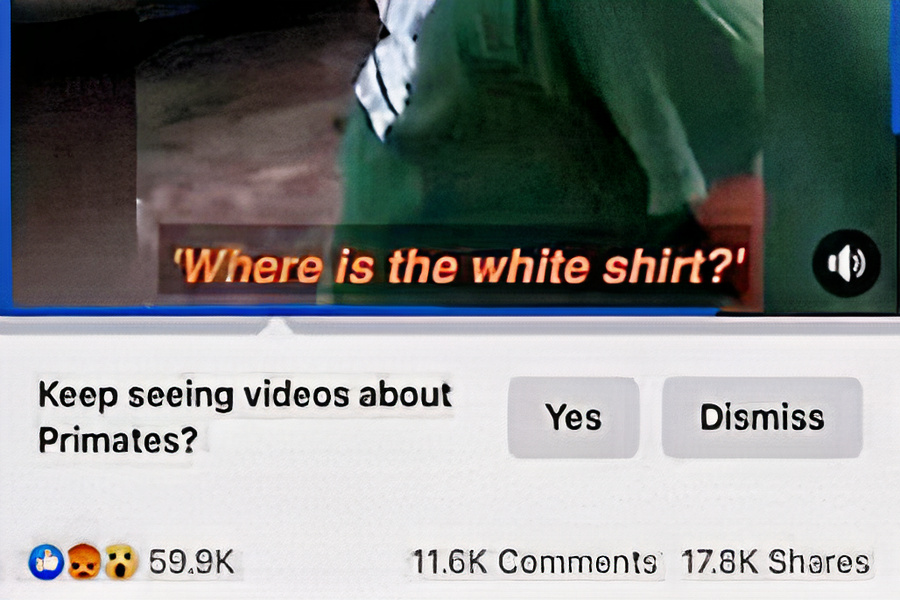

Facebook извинился за функцию искусственного интеллекта, которая спрашивала пользователей, хотят ли они “продолжать смотреть видео о приматах” после просмотра видео Daily Mail с участием чернокожих мужчин.

New York Times сообщила, что видео содержало нарезку роликов с “чернокожими мужчинами, вступающими в стычки с белыми гражданскими лицами и полицейскими” и “не имело никакого отношения к обезьянам или приматам”. Видео было опубликовано в июне 2020 года; как долго оскорбительная подсказка показывалась пользователям в отчете не сообщалось. Алгоритм искусственного интеллекта, применивший рекомендацию к этому видео, был отключен на время изучения причин ошибки.

Это уже не первый раз, когда происходят подобные сбои в системах ИИ. Например, в 2015 году Google Photos отсортировал изображение двух чернокожих людей в категорию “гориллы”, а Twitter недавно подтвердил, что его алгоритм обрезки изображений чаще выбирал белых людей.

Предвзятость искусственного интеллекта также была обнаружена в функциях, связанных с распознаванием лиц, здравоохранением и другими областями. Тем не менее, технологические компании все чаще используют технологии ИИ в своих сервисах, приложениях и оборудовании, несмотря на сохраняющиеся опасения по поводу ошибочности алгоритмов.

“Несмотря на то, что мы уже улучшили наши алгоритмы, мы знаем, что они все еще не идеальны, и нам предстоит пройти долгий путь”, ー заявила пресс-секретарь Facebook Дэни Левер газете NYT. “Мы приносим извинения всем, кто мог увидеть эти оскорбительные рекомендации”.